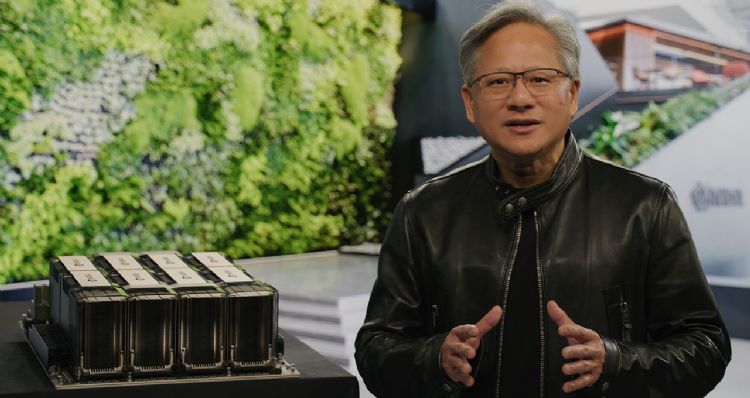

NVIDIACEO黄仁勳在GTC 大会主题演讲中表示将把人工智能带入各产业。NVIDIA

随着如今运算技术出现他所说的「光速」发展速度,NVIDIA创始人暨CEO黄仁勳宣布与Google、微软、Oracle(甲骨文)及多家重量级企业展开更大规模的合作活动,将为各行各业带来崭新的人工智能、模拟及协作能力。黄仁勳在NVIDIA的GTC大会主题演讲中表示:「曲速引擎是加速运算,而它的能量来源正是人工智能。生成式人工智能的出色能力,让各大企业开始对于重新构思产品和商业模式有了迫切感。」

黄仁勳发表了长达78分钟的主题演讲,替为期四天的GTC大会揭开序幕,演讲中介绍了NVIDIA与合作夥伴如何为尖端人工智能服务提供从训练到部署的各项内容。他宣布推出新款半导体和软件库,以协助推动新的突破研究成果。

黄仁勳还宣布将推出一整套系统和服务,供全球竞相落实这些创新项目的新创公司及企业使用。黄仁勳不时在演讲中用生动的例子,说明这个生态系统所扮演的角色。并宣布NVIDIA与微软将把数亿名Microsoft365 及Azure使用者与用于建立及运作超现实虚拟世界的平台连结起来。他带领观众们了解Amazon(亚马逊)如何使用复杂的模拟能力来训练新式自主仓库机器人。他也在演讲中谈到像是ChatGPT 这类新一代大受欢迎生成式人工智能服务的出现。

黄仁勳在强调NVIDIA进行创新的基础本质时,详细介绍了NVIDIA在运算微影技术的突破性成果,是如何与 ASML、台积电及Synopsis合作打造出新一代高效强大的2纳米半导体。黄仁勳表示加速运算与人工智能来的正是时候,随着摩尔定律的放缓,各行各业都在因应永续发展、生成式人工智能及数码化这些强大驱动市场前行的动能所带来的挑战。「工业领域里的业者争相进行数码化,将自己重新塑造为软件驱动的科技公司- - 企图成为颠覆市场的人,而非被市场颠覆的人。」

黄仁勳说。加速运算技术可以协助这些业者因应这些挑战。黄仁勳说:「加速运算是减少用电量、达到永续发展及净零排放目标的最佳途径。」

GTC大会:规模最大的人工智能盛会

走过十四个年头的GTC大会,俨然成为全球最重要的人工智能盛会之一。2023年的GTC大会共有650场讲座,特别力邀DeepMind的Demis Hassabis、阿贡国家实验室的Valeri Taylor、Adobe 的 Scott Belsky、Netflix的Paul Debevec、苏黎世联邦理工学院的Thomas Schulthess等重量级贵宾,以及黄仁勳与 OpenAI的共同创始人,也是建立ChatGPT的Ilya Sutskever,进行一场特别的炉边谈话。有超过25万人报名参加2023年的GTC大会,将能够深入探讨从修复两千年前遗失的罗马马赛克图案,到打造未来工厂;从使用新一代大型望远镜探索宇宙,到重新排列分子以加速药物发现,以及超过70场关于生成式人工智能的演讲。

人工智能迎来 iPhone 时刻

NVIDIA的技术是发展人工智能的基础,黄仁勳讲述了NVIDIA如何在生成式人工智能革命的初期便参与其中。他早在2016年便亲手将第一台NVIDIA DGX人工智能超级电脑交给OpenAI,这是用于在背后支持 ChatGPT 这项大型语言模型出现突破性成果的引擎。

2022年底甫亮相的ChatGPT,几乎瞬间成为市场当红主流,吸引超过一亿人使用,成为史上成长速度快的应用程序。「我们正处于人工智能的 iPhone 时刻。」黄仁勳说。黄仁勳表示 NVIDIA DGX 超级电脑一开始是当成研究人工智能的工具,如今全球各地的企业一整天都在运行这具超级电脑,以完善数据和处理人工智能。财富100强(Fortune 100)排行榜中有半数的企业都装有 DGX AI 超级电脑。「DGX超级电脑是现代人工智能工厂。」黄仁勳说。

用于数据中心的NVIDIA H100、Grace Hopper、Grace

黄仁勳表示部署像ChatGPT这样的大型语言模型,是一新式的、相当重要的推论工作负载。黄仁勳宣布针对像是ChatGPT这样类型的大型语言模型推论作业推出新款GPU,即拥有双GPU NVLink的H100 NVL。

采用NVIDIA Hopper架构的H100具有一个Transformer引擎,用于处理像是支持ChatGPT的GPT等模型。与用于处理GPT-3的HGX A100相比,一台搭载四对H100及双GPU NVLink的标准服务器,其处理速度最高可提升十倍。「H100 可以将处理大型语言模型的成本降低一个数量级,」黄仁勳说,「同时在过去十年里,云端运算市场的规模每年成长20%,产业市值达到一万亿美元。」

NVIDIA设计用于人工智能及云端优先环境的Grace CPU,由GPU加速执行各项人工智能工作负载。黄仁勳说现正将Grace的样品送给各大厂商进行测试。NVIDIA的新款超级芯片Grace Hopper,以每秒 900GB 的高速一致性芯片到芯片(chip-to-chip)界面连接Grace CPU和Hopper GPU。黄仁勳说Grace Hopper是处理用于推荐系统的人工智能数据库,还有大型语言模型这一类海量数据集的理想选择。并补充道:「客户想要把人工智能数据库扩大几个数量级。Grace Hopper 是理想的引擎。」

DGX是打造人工智能基础设施的蓝图

最新版的DGX搭载8个NVIDIA H100 GPU,这8个GPU连在一起变成一个巨大的GPU来处理各项工作。黄仁勳说:「NVIDIA DGX H100是全球客户建造人工智能基础设施的蓝图。」,并且分享NVIDIA DGX H100 现已全面投产。

H100 人工智能超级电脑已经上线。Oracle Cloud Infrastructure 宣布限量推出搭载 H100 GPU 的新式 OCI Compute 裸机 GPU 执行个体。

此外,Amazon Web Services宣布即将推出P5执行个体的EC2 UltraClusters,其规模可以扩大到两万个互连的H100 GPU。微软Azure才在上周宣布推出H100虚拟机器 ND H100 v5 的非公开专属预览活动。Meta 在公司内部部署了供人工智能生产和研究团队使用、搭载H100的Grand Teton AI超级电脑。OpenAI将在其Azure超级电脑上使用H100,以持续支持其人工智能研究。其他提供 搭载H100云端平台服务 的合作夥伴还有Cirrascale及CoreWeave,这两家公司今天都宣布全面提供。此外,Google Cloud、Lambda、Paperspace及Vult计划推出搭载H100的云端平台。

各大服务器制造商现已开始提供搭载NVIDIA H100 GPU的服务器和系统,这些业者有源讯(Atos) 、思科系统(Cisco) 、戴尔科技集团(Dell Technologies)、技嘉科技、慧与科技公司(Hewlett Packard Enterprise)、联想集团 (Lenovo)及 美超微电脑 (Supermicro)。

DGX Cloud:立即将人工智能带给每个公司

黄仁勳宣布推出NVIDIA DGX Cloud,与微软Azure、Google Cloud 及 Oracle Cloud Infrastructure 合作,「每间公司只要简单透过网络浏览器就能使用NVIDIA DGX AI超级电脑」,让那些争相打造新产品及制定人工智能策略的新创公司和企业可以更快取得DGX的强大实力。完成最佳化调整的DGX Cloud可以运行 NVIDIA AI Enterprise,这是独步全球的加速软件套件,用于端到端的人工智能开发和部署作业。「DGX Cloud把NVIDIA AI技术的精华,还有全球各大云端服务提供商的优点都交到客户的手上。」黄仁勳说。

NVIDIA与各大云端服务提供商合作托管DGX Cloud 基础设施,由Oracle Cloud Infrastructure抢得头香。微软Azure预计将在下一季开始托管DGX Cloud,Google Cloud等其他业者将随后跟上。黄仁勳表示这项合作关系将NVIDIA的生态系统带给云端服务提供商,又扩大了NVIDIA的规模和接触范围。企业将能够按月租用DGX Cloud丛集,确保他们可以轻松快速地调整发展大型多节点训练工作负载的规模。

助力生成式人工智能的发展

黄仁勳宣布推出NVIDIA AI Foundations云端服务系列,供需要建立、完善和操作自订大型语言模型,以及使用专有数据来训练生成式人工智能以执行特定领域任务的客户使用,让想要利用生成式人工智能的人可以加速执行各项工作。AI Foundations服务包括用于建立自订语言文字转文字生成式模型的NVIDIA NeMo;Picasso视觉语言模型制作服务,适用于想要建立用取得授权或专有内容来训练自订模型的客户;以及 BioNeMo,供市值两万亿美元药物发现产业的研究人员使用。

Adobe与NVIDIA合作打造一套适用于未来创意人的下一代人工智能功能。Getty Images与NVIDIA合作训练开发负责任的生成式文字转图片及文字转影片基础模型。Shutterstock与NVIDIA合作训练一个生成式文字转3D的基础模型,让建立精细3D资产的工作变得更简单。

加速推动医学领域进步

NVIDIA 宣布 Amgen(安进)将使用 BioNeMo 加快推动药物发现服务。Alchemab Therapeutics、AstraZeneca、Evozyne、Innophore 及 Insilico 也都是抢先试用 BioNemo 的客户。黄仁勳说 BioNeMo 帮助研究人员用他们自己的专有数据来建立、微调和自订模型。

黄仁勳另宣布NVIDIA与全球最大的医疗科技提供商Medtronic(美敦力)合作,为软件定义的医疗设备建立人工智能平台。这项合作关系将为Medtronic旗下的手术导航,以及机器人辅助手术等系统建立一个通用平台。Medtronic宣布该公司使用NVIDIA Holoscan打造出的GI Genius系统,透过人工智能对大肠结肠癌进行早期检测。NVIDIA Holoscan是用于实时传感器处理系统的软件库,将于2023年底左右出货。「全球市值2500亿美元的医疗仪器市场将进行转型。」黄仁勳说。

加速部署生成式人工智能应用程序

黄仁勳宣布推出用于人工智能影片、影像生成、LLM部署及推荐系统推论作业的推论平台,以帮助企业部署快速兴起的生成式人工智能模型。在这个平台中结合了NVIDIA推论软件的完整堆叠和最新的NVIDIA Ada、Hopper及Grace Hopper处理器,包括推出的NVIDIA L4 Tensor核心GPU与NVIDIA H100 NVL GPU。

用于人工智能影片的NVIDIA L4,其制作人工智能影片的效能较CPU多出120倍,能源使用效率也提高99%。用于影像生成的NVIDIA L40针对绘图及人工智能生成的2D、影片和3D影像进行了最佳化调整。

用于部署大型语言模型的NVIDIA H100 NVL是大规模部署像是ChatGPT这类大型语言模型的理想选择。

用于推荐模型的NVIDIA Grace Hopper是图形推荐模型、矢量图形数据库及绘图神经网络的理想选择。

Google Cloud是率先将L4提供给客户的云端服务提供商,推出了新款G2虚拟机器,开放非公开专属预览活动。Google也将在Vertex AI模型商店中加入L4。

微软与NVIDIA将把Omniverse带给「数亿」人使用

黄仁勳在公布第二项云端服务,让企业更快取得前所未有的模拟及协作能力时,宣布 NVIDIA 将与微软合作,让全球各行各业可以使用到NVIDIA Omniverse Cloud这项完全托管的云端服务。黄仁勳表示:「微软与NVIDIA将合作让数亿名Microsoft 365和Azure用户可以使用到 Omnivese。」他还公布新款NVIDIA OVX服务器与新一代工作站产品,在这些产品上搭载了NVIDIA RTX Ada Generation GPU及Intel针对 NVIDIA Omniverse进行最佳化的最新款 CPU。

黄仁勳为展示 NVIDIA 替 3D 设计协作和数码孪生模拟而打造的开放式 Omniverse 平台出色功能,透过一支影片展示建立在 Omniverse 上的 NVIDIA 机器人模拟和合成生成平台 NVIDIA Isaac Sim,如何制作出极具真实感的数码孪生模型,协助用户节省宝贵的金钱和时间。在这支影片中可以看到 Amazon(亚马逊)如何努力编排 Amazon 首个全自主仓库机器人 Proteus 的动作,它在 Amazon 宽敞的仓库中与人类及其他机器人共同将一箱箱产品从一处搬到另一处。

市值三万亿美元的汽车产业将进行数码化

黄仁勳深入介绍 Omniverse 在带领市值三万亿美元之汽车产业进行数码化的过程中所扮演的角色,让更多人明白 Omniverse 的影响力和能力。黄仁勳表示到2030年之际,汽车制造商将建造出三百座工厂,生产两亿辆电动车,而电池制造商正在兴建百座巨型工厂。「数码化将提高产业的效率、生产力和速度。」黄仁勳说。

在谈到整个车业使用Omniverse的情况时,黄仁勳表示吉利路特斯(Geely Lotus)使用Omniverse来开发虚拟的装配焊接站。Mercedes-Benz使用Omniverse为新车款建立、最佳化及规划装配线。Rimac与Lucid Motors使用Omniverse使用实际的设计数据来建立数码商店,原原本本地表现车款的样子。BMW与 Idealworks合作使用Omniverse中的Isaac Sim,产生各种合成数据和情境来训练工厂机器人。

黄仁勳说,BMW使用Omniverse来规划全球各处工作的运作,另外还在工厂落成启用前,以两年时间完全在Omniverse中规划一处新的电动车工厂。NVIDIA此外还宣布领先全球的新能源车(NEV)制造商比亚迪,将扩大把NVIDIA DRIVE Orin集中运算平台用在旗下更多的NEV车款。

加速推动半导体业取得突破性创新成就

由于当前的半导体制程已接近物理学的极限,黄仁勳宣布推出NVIDIA cuLitho,这项突破性技术将加速运算技术用于运算微影领域,能够帮助ASML、台积电与Synopsis等半导体领导业者加速推动设计与制造出新一代的芯片。全球最大的晶圆代工厂台积电与电子设计自动化领导业者Synopsys,将用于运算微影技术的全新NVIDIA cuLitho软件库加入其最新一代NVIDIA Hopper架构GPU的软件、制程及系统中。

芯片制造设备供应商ASML与NVIDIA就GPU及cuLitho进行密切合作,并且打算让旗下每一款运算微影软件产品开始支持GPU。黄仁勳表示由于微影技术处于物理学的极限,NVIDIA推出的cuLitho将使得半导体业能够产生出2纳米及更先进的半导体。「芯片业几乎是各行各业的基础。」黄仁勳说。

加速全球每个最大企业的运作效率

全球各大企业纷纷挺身支持黄仁勳的远大愿景。电信大厂AT&T使用NVIDIA AI以提高处理数据的效率,且正在测试Omniverse ACE和Tokkio人工智能虚拟化身工作流程,为客服部门和员工服务台建立、自订及部署虚拟助理。美国运通、美国邮政署、Microsoft Office和Teams,以及Amazon等4万名客户,使用高效能 NVIDIA TensorRT推论优化器和运行时,还有多架构数据中心推论服务软件NVIDIA Triton来促进其工作效率。

Uber使用Triton,每秒预测数10万次预计抵达时间(ETA)。每天拥有超过6,000万名活跃用户的Roblox,使用 Triton 来提供游戏推荐模型、建立数码分身,以及管理内容和市场广告。微软、腾讯与百度都在人工智能电脑视觉作业方面开始使用NVIDIA CV-CUDA。NVIDIA CV-CUDA技术现为公测阶段,针对前制及后制作业进行最佳化调整,有助于省下四倍的成本及能源使用量。

协助将不可能化为可能

黄仁勳在主题演讲的尾声,对NVIDIA的系统、云端及软件合作夥伴,以及所有研究人员、科学家和员工表达谢意。黄仁勳宣布NVIDIA已经更新了100个加速库,包括用于量子计算的cuQuantum和全新开放原始码的CUDA Quantum、用于组合最佳化的cuOpt,以及用于运算微影技术的cuLitho。黄仁勳表示NVIDIA 的全球生态系统现有400万名开发人员、4万家公司加入,而NVIDIA Inception计划则有1.4万间新创公司加入。黄仁勳说:「如此庞大的生态系统将协助全球各领域把不可能化为可能。」

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。